Welcome back, Pionero. Tu LLM dice que procesa un millón de tokens. Un nuevo estudio demuestra que a partir de 70.000 el rendimiento cae a nivel de tirar una moneda al aire.

Hoy: el mito del contexto largo al descubierto, el modelo open-weight de Alibaba, y el despegue de $100M del vibe-coding.

🔒 La ventaja que tu competencia no tiene (todavía)

Claude Co-Work puede cambiar tu forma de trabajar. En 10 minutos sabrás exactamente cómo. No está a la venta — solo se desbloquea recomendando IA al Día a 1 persona.

Lo Esencial

1. Alibaba lanza Qwen 3.5 — open-weight, pensado para agentes y apuntando a GPT-5: El equipo Qwen de Alibaba ha lanzado Qwen3.5-397B, un modelo sparse MoE con 397B parámetros totales pero solo 17B activos en inferencia. El resultado: decodificación entre 8,6x y 19x más rápida que equivalentes densos, a un 60% menos de coste. El modelo viene con ventana de contexto nativa de 1M de tokens, capacidades multimodales con early fusion y licencia Apache 2.0 totalmente abierta. Alibaba asegura que supera a GPT-5.2, Claude Opus 4.5 y Gemini 3 Pro en el 80% de los benchmarks — incluyendo un 91,3 en AIME26 y 83,6 en LiveCodeBench v6. Si los tests independientes lo confirman, es el modelo open-weight más potente disponible ahora mismo.

2. El creador de OpenClaw ficha por OpenAI — pero el agujero de seguridad sigue ahí: Peter Steinberger, creador de OpenClaw — el agente de IA open-source con 196K estrellas en GitHub — se une a OpenAI. Sam Altman lo describió como "un genio con ideas increíbles sobre agentes muy inteligentes". OpenClaw seguirá como proyecto open-source con el respaldo de OpenAI. El momento no es casual: Bitdefender descubrió recientemente casi 900 skills maliciosas en el registro ClawHub de OpenClaw — cerca del 20% de todos los paquetes — además de una vulnerabilidad RCE crítica y más de 135K instancias expuestas. OpenAI adquiere talento, pero también hereda un problema de seguridad serio.

3. Emergent alcanza $100M de ARR en ocho meses — el despegue más rápido del vibe-coding: Emergent, con sede en India, ha cruzado los $100M de ingresos recurrentes anuales en solo ocho meses desde su lanzamiento, duplicando los $50M en un solo mes. La plataforma de vibe-coding tiene ya más de 6M de usuarios en 190 países, y el 70% no tiene experiencia en programación. Más del 80% de los nuevos proyectos son apps móviles. En enero cerró una Serie B de $70M con una valoración de $300M — la primera apuesta nueva de SoftBank en India en cuatro años. La ola del no-code no frena.

Lo que pierdes

Tu bandeja de entrada no es gratis — la pagas con datos.

Cada vez que abres Gmail o Outlook, alguien más también está mirando.

No es paranoia. Es el modelo de negocio. Los proveedores de correo gratuito procesan tu contenido para mostrarte anuncios, entrenar sistemas o venderle datos a terceros. Tú no recibes una factura porque tú eres lo que se vende.

Lo que estás perdiendo no es solo privacidad en abstracto. Es el control sobre tus contratos, tus negociaciones, tus conversaciones más sensibles.

Llevo tiempo usando Proton Mail para exactamente eso. Sin anuncios, sin escaneo, cifrado de extremo a extremo. Y puedes probarlo gratis, sin comprometerte a nada, sin tocar tu correo actual. Solo entrar, ver cómo funciona y decidir.

Free, private email that puts your privacy first

A private inbox doesn’t have to come with a price tag—or a catch. Proton Mail’s free plan gives you the privacy and security you expect, without selling your data or showing you ads.

Built by scientists and privacy advocates, Proton Mail uses end-to-end encryption to keep your conversations secure. No scanning. No targeting. No creepy promotions.

With Proton, you’re not the product — you’re in control.

Start for free. Upgrade anytime. Stay private always.

En Portada

La ventana de contexto de un millón de tokens de tu LLM es un número de marketing

El test que los rompió. Un nuevo estudio de febrero de 2026 puso a prueba a GPT-5, Grok-4, GPT-4 y Gemini 2.5 Pro en tareas reales de contexto largo — no benchmarks sintéticos, sino hilos orgánicos de Reddit que exigían encontrar, sintetizar y razonar a través de miles de publicaciones. Los resultados incomodan. Por encima de 5.000 posts (~70K tokens), la precisión de todos los modelos cayó al 50–53%. Eso es tirar una moneda al aire. GPT-5 maneja un millón de tokens sobre el papel. En la práctica, su ventana útil es apenas el 7% de eso.

Precision vs. recall — una diferencia clave. Aquí viene el matiz que importa. GPT-5 mantuvo un 95% de precision en la longitud máxima de contexto — cuando daba una respuesta, casi siempre era correcta. Pero el recall se desplomó. El modelo simplemente dejaba de encontrar información relevante enterrada en documentos largos, optando por el silencio en vez de alucinar. Es un modo de fallo mejor que inventarse cosas, pero significa que datos críticos en tu contrato de 200 páginas o en tu base de código pueden pasar completamente desapercibidos.

El fix del "lost in the middle" — y el nuevo problema. Una buena noticia: el clásico patrón de context rot — donde los modelos ignoran la información en la zona media de inputs largos — está en gran parte resuelto en GPT-5 y Grok-4. Recuperan información de forma más uniforme a lo largo de todas las posiciones. Pero resolver el sesgo posicional no arregló los límites de capacidad. El cuello de botella pasó de dónde miran los modelos a cuánto pueden procesar realmente. Un millón de tokens es un tamaño de contenedor, no una garantía de comprensión.

Qué significa esto para ti. Si estás construyendo pipelines de RAG, flujos de agentes o herramientas enterprise que dependen del rendimiento en contexto largo, estos datos son un baño de realidad. El chunking, las estrategias de retrieval y la gestión inteligente del contexto siguen importando — posiblemente más que nunca. La distancia entre las ventanas de contexto anunciadas y la usabilidad real no es un bug. Es el estado actual de la tecnología. Planifica en consecuencia.

IA Aplicada

Convierte la novedad en tu ventaja competitiva: cómo crear informes sectoriales con nivel McKinsey usando Kimi K2.5

Entra en Kimi y regístrate.

Selecciona «Kimi 2.5 Agent» como modelo e introduce tu prompt.

Prompt de ejemplo:

«Elabora un informe “Líderes Globales en Robótica 2025 – Comparativa de Hoja de Ruta Tecnológica”. Analiza 12 empresas líderes en robótica (humanoide, industrial y logística). Compara: hardware stack, actuadores y reductores, sensores, arquitectura de IA (end-to-end vs modular), nivel de autonomía, escala de fabricación y control de la cadena de suministro. Incluye: Matriz de Comparación Tecnológica, Cuadro de Evaluación de Capacidades de IA, Mapa de Cadena de Suministro y un gráfico de Cuadrante 2x2 posicionando a las empresas. Inserta el logotipo oficial de cada compañía en sus perfiles y en la visualización del cuadrante. Estilo: informe institucional de equity research con tablas limpias y gráficos estratégicos.»

En pocos minutos obtendrás un archivo Word con visualizaciones de datos a nivel consultoría, mapas de calor técnicos y marcos estratégicos.

Productividad

5 Herramientas Que Valen la Pena

✨ QuikAuthor: Convierte vídeos, PDFs y prompts de texto en cursos interactivos y gamificados de e-learning.

📖 AIWriteBook: Escribe y publica un libro en KDP en cuestión de horas con IA.

📱 AptiBuild: Transforma tus talentos ocultos en ideas de apps rentables en minutos.

💼 Reztune: Reescribe y formatea tu currículum al instante para cualquier oferta de empleo.

Listo para Usar

Copy de landing page de alta conversión

Prompt: Actúa como un redactor profesional especializado en direct response y marketing digital. Escribe una landing page de alta conversión para un producto o servicio en el sector de [tu nicho, p. ej., coaching online, herramienta SaaS, plantillas digitales].

El objetivo de la página es [objetivo – p. ej., captar leads, vender un producto, agendar llamadas de descubrimiento].

Incluye las siguientes secciones:

• Un titular que capte la atención

• Un subtítulo convincente

• Un gancho breve y atractivo para introducir la oferta

• Una lista con 4–6 beneficios (no características)

• Una sección de llamada a la acción potente con texto para el botón

• Una breve biografía «Sobre el creador» para generar confianza

• Una sección que aborde objeciones o dudas comunes

• Opcional: un testimonio de cliente en 2 líneas

Mantén el tono [tono deseado: cercano / profesional / atrevido], y haz que el texto sea persuasivo, fácil de escanear y emocionalmente convincente.

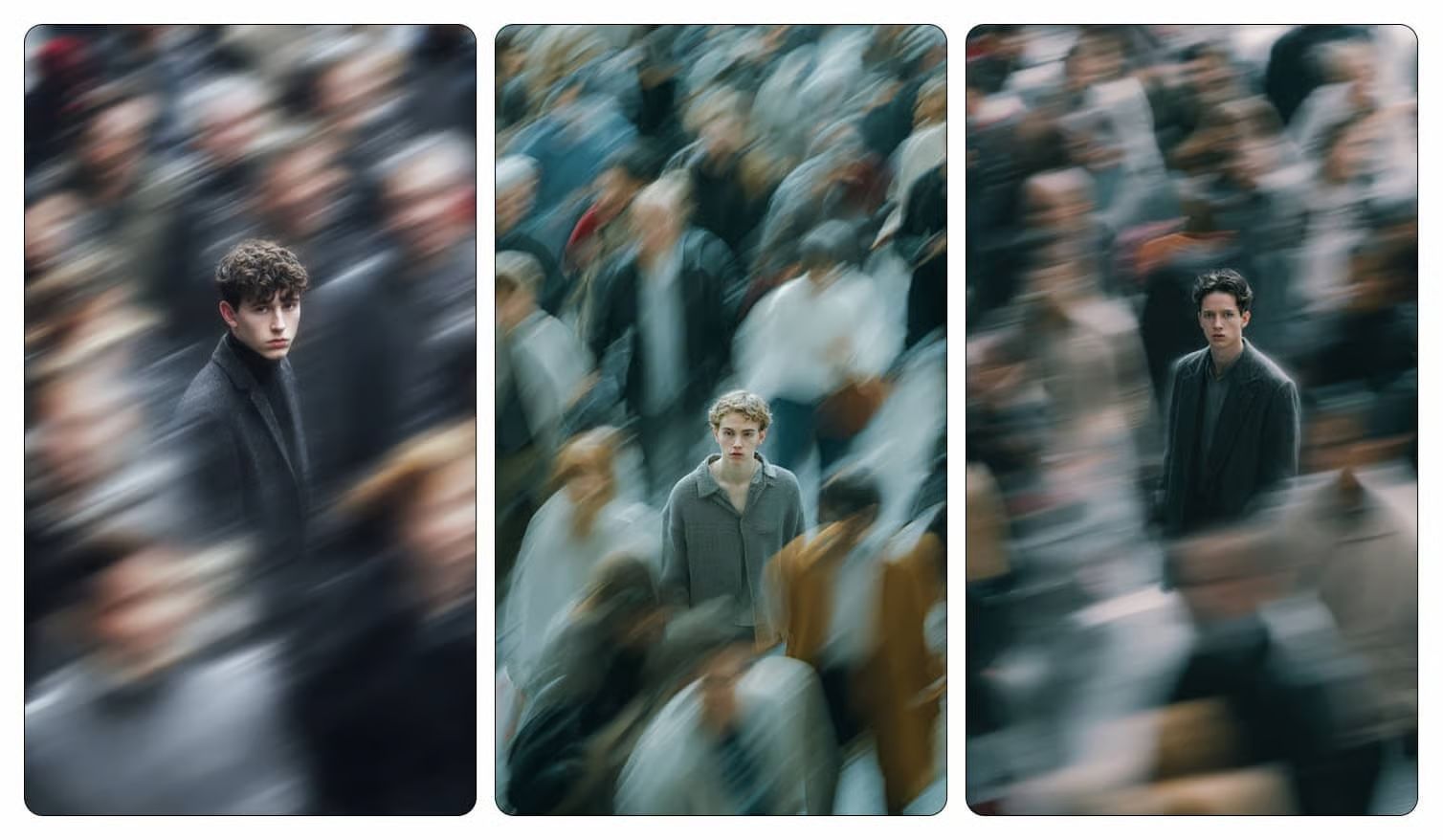

Usa un lenguaje sencillo y un formato que convierta bien en móvil.Fotografía cinematográfica con movimiento

Prompt NanoBanana: Fotografía cinematográfica con desenfoque de movimiento, tomada con una Leica SL3 y un 50mm Summilux a f/2.8, capturada desde un ángulo frontal a la altura del pecho utilizando panning con obturación lenta.

Iluminación: cielo nublado uniforme actuando como difusor suave, permitiendo largas estelas de desenfoque sin contraste agresivo.

Tono de color: grises cemento apagados y tonos de piel neutros pálidos inspirados en películas de A24.

Sujeto: modelo masculino de la Generación Z completamente inmóvil, mirada nítida, rostro simétrico, poros reales visibles, vestido con moda sobria y minimalista.

Acción del entorno: cientos de personas pasando apresuradamente en todas direcciones, cuerpos convertidos en estelas suaves horizontales y diagonales.

Emoción: rebelión silenciosa a través de la quietud.

Estética: calma editorial frente al caos.

Postproducción: física de movimiento limpia, grano fino, sin fallos, sin distorsión facial, sin deformaciones. –ar 4:5 –raw anatomyCuando estés listo para dar el siguiente paso

La IA no te va a reemplazar. Te va a reemplazar alguien que sepa usarla. Este curso gratuito de 5 días te enseña lo esencial: prompts efectivos, fundamentos de automatización, y cuándo los agentes son mejores que los workflows. ¿Listo para subir de nivel?